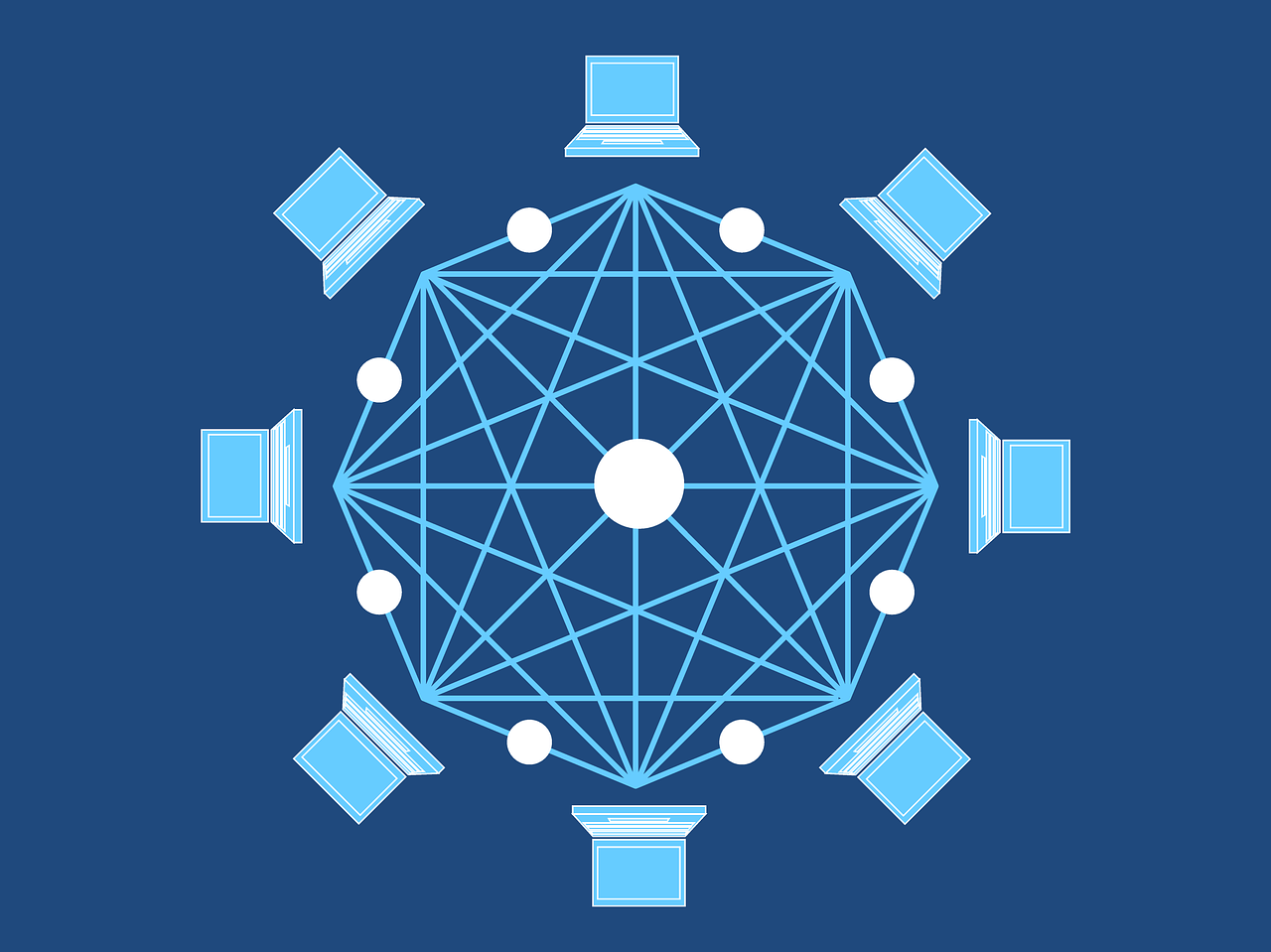

BP神经网络拓扑结构

神经网络作为人工智能领域的核心技术之一,其拓扑结构直接决定了网络的性能和适用场景,BP(Back Propagation)神经网络作为最经典的前馈神经网络,以其独特的误差反向传播算法在模式识别、函数逼近和预测分析等领域得到广泛应用。

基本组成单元

BP神经网络由三个基本层次构成:

- 输入层:负责接收外部输入数据,节点数量通常与输入特征维度一致

- 隐含层:介于输入层和输出层之间,负责特征的非线性变换

- 输出层:产生网络的最终输出,节点数量取决于输出需求

各层之间通过带有权重的连接线完全相连,形成”全连接”的网络结构。

典型拓扑结构

单隐含层结构

最基本的BP网络结构包含:

- 一个输入层

- 一个隐含层

- 一个输出层

这种结构理论上可以逼近任何连续函数,适合解决大多数常见问题。

多隐含层结构(深度网络)

随着问题复杂度的提升,现代BP网络常采用:

- 多个隐含层

- 每层不同的节点数量

- 层间不同的连接方式

这种深度结构能够学习更复杂的特征表示,但同时也面临梯度消失、训练困难等挑战。

连接方式分类

- 前馈连接:信号单向流动,从输入层经隐含层到输出层

- 跨层连接:存在跳过中间层的直接连接

- 反馈连接:输出信号可反向影响前面层的节点状态

参数配置要点

- 隐含层数量:通常1-3层,复杂问题可增加

- 节点数量:遵循”由少到多”原则,避免过拟合

- 激活函数选择:Sigmoid、ReLU、Tanh等

- 学习率设置:影响收敛速度和稳定性

应用场景匹配

- 简单分类问题:单隐含层,少量节点

- 图像识别:多隐含层,卷积结构

- 时序预测:带反馈连接的递归结构

- 复杂函数逼近:深层网络配合适当正则化

结构优化策略

- 网络剪枝:移除冗余连接和节点

- 权值共享:减少参数数量

- 模块化设计:构建子网络组合

- 进化算法:自动优化结构参数

BP神经网络的拓扑结构设计需要结合具体问题和数据特性,通过实验验证确定最优配置,随着深度学习技术的发展,新型网络结构不断涌现,但BP网络的基本原理仍然是理解现代神经网络的重要基础。

参考文献:

- Rumelhart, D. E., Hinton, G. E., & Williams, R. J. (1986). Learning representations by back-propagating errors. Nature.

- Haykin, S. (2009). Neural networks and learning machines. Pearson Education.

- 周志华. (2016). 机器学习. 清华大学出版社.

九八云安全

九八云安全