分布式数据管理组装的核心要素与实现路径

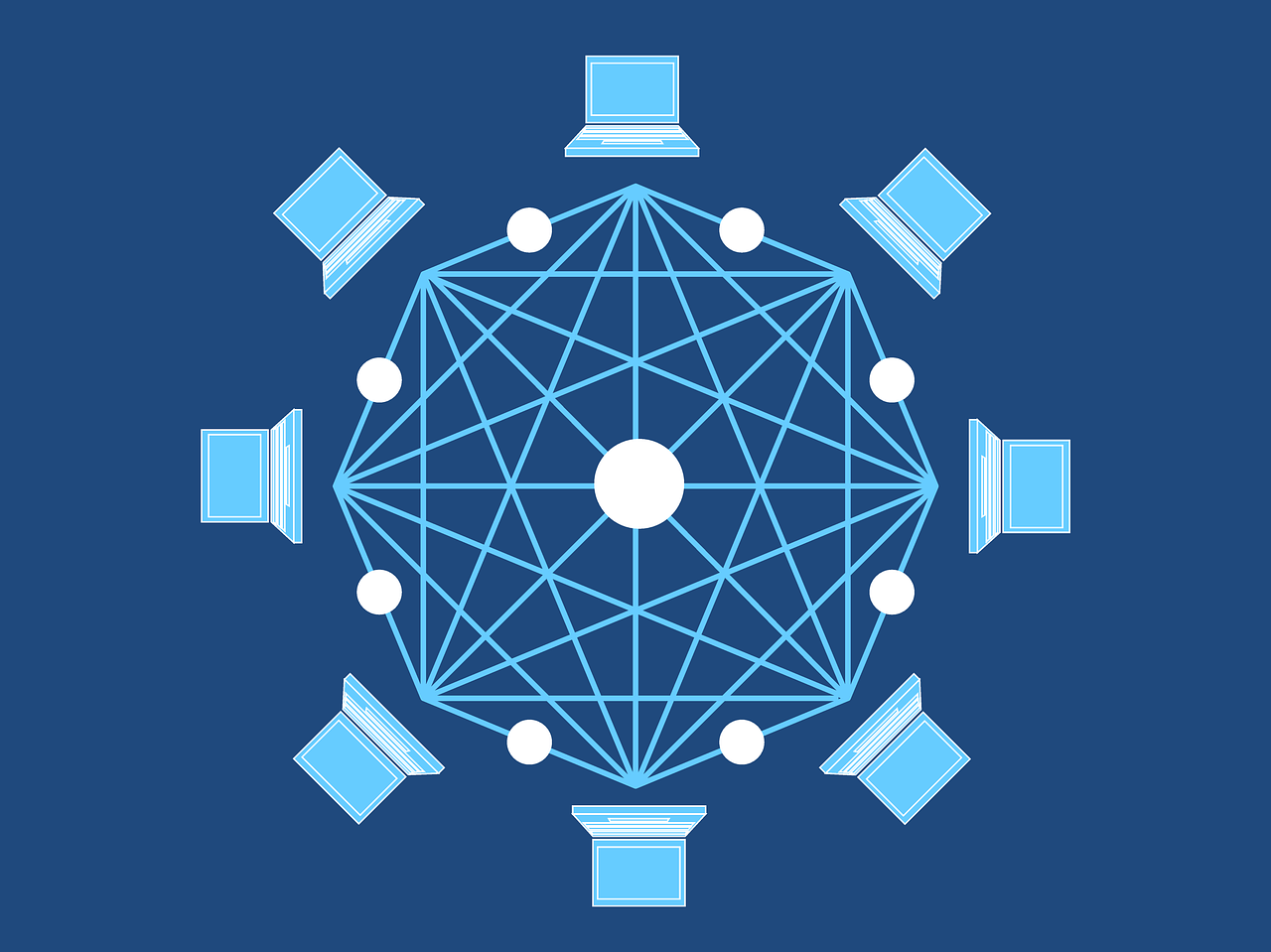

在分布式系统中,数据管理是决定系统性能、扩展性和可靠性的关键,如何将分散在不同节点的数据进行高效组装,形成统一的逻辑视图并保障数据一致性,是分布式架构设计的核心挑战,以下从数据分片、复制机制、元数据管理、全局事务处理、容错策略五个维度展开分析,并提供可落地的技术方案。

实施要点:

- 分片键选择:需具备高离散性(如UUID)或业务相关性(如用户ID),避免热点数据集中

- 分片粒度控制:机械硬盘时代建议KB级分片,SSD时代可扩大至MB级

- 动态扩容机制:采用一致性哈希算法(如RingHash)实现节点增减时的数据最小迁移

典型案例:某电商平台将订单数据按用户ID后两位哈希分片,同时按日期范围建立二级分片,既保证用户查询的局部性,又便于历史数据归档。

数据复制机制:平衡可用性与一致性

| 复制模式 | 同步强度 | 数据一致性 | 适用场景 |

|---|---|---|---|

| 主从复制 | 异步 | 最终一致 | 读多写少场景(如商品浏览) |

| 链式复制 | 同步 | 强一致 | 金融交易系统 |

| 多主复制 | 因果一致 | 会话级一致 | 协同编辑系统(如Google Docs) |

关键技术:

- Paxos/Raft协议:用于选举主节点和日志复制(如etcd、Consul实现)

- 冲突检测:通过版本向量(Vector Clock)或CRDTs(冲突自由复制数据类型)解决并发写入

- 读写分离策略:设置延迟阈值(如50ms)自动切换读请求到近源副本

性能优化:

实现方案:

- 双层缓存架构:本地缓存(Guava Cache)+ 分布式缓存(Redis Cluster)

- 拓扑感知路由:结合网络延迟矩阵(如Netflix Edgware)动态选择最近副本

- 版本化元数据:采用MVCC(多版本并发控制)处理更新冲突

典型架构:

客户端 → 路由层(Envoy/Nginx) → 元数据服务集群 → 存储节点

↑ ↑ ↑

└───────────────────────┘ └──健康检查心跳包

全局事务处理:破解分布式ACID难题

| 事务模型 | 适用场景 | 技术实现 |

|---|---|---|

| 2PC协议 | 短事务(<1s) | XA规范实现(如Atomikos) |

| TCC补偿 | 长事务(>10s) | 本地日志+补偿脚本(如支付宝账务体系) |

| Saga模式 | 跨服务业务流程 | Choreography编排(如Nacos+Dubbo) |

| 乐观锁 | 低冲突场景 | 版本号机制(如Cassandra LWT) |

性能优化策略:

- 事务切分:将大事务拆解为多个小事务(如订单创建拆分为库存扣减+支付)

- 异步最终一致性:引入消息队列(Kafka/RocketMQ)解耦事务边界

- 基数估计算法:使用HyperLogLog统计去重数据,减少精确计算开销

容错与恢复机制:构建弹性数据层

| 故障类型 | 应对策略 | 恢复时间目标 |

|---|---|---|

| 节点宕机 | 自动故障转移+数据重均衡 | <30s |

| 网络分区 | CAP策略选择(默认AP模式) | 数据修复<1min |

| 数据损坏 | 校验和+增量校验(如CRC64+Merkle Tree) | 坏块检测<10ms |

关键技术:

- 反熵协议:定期(如每分钟)进行数据块比对,自动修复不一致

- 混沌工程:模拟网络延迟(TCP latency注入)、磁盘故障(IOError抛出)

- 多副本仲裁:采用Quorum NWR策略(写多数,读多数)

FAQs

Q1:如何选择合适的分片键?

A:需综合考虑三个维度:① 业务访问模式(如按用户ID分片利于点查询);② 数据增长特性(时间分片适合日志类数据);③ 分片键基数(建议哈希后空间>=10倍节点数),可通过分析查询日志中的WHERE条件频率来验证选择。

Q2:数据倾斜导致部分节点过载怎么办?

A:采用三级应对策略:① 动态分片(如按用户等级二次分片);② 冷热数据分离(SSD存热数据,HDD存冷数据);③ 负载均衡调度(基于CPU/IO利用率的实时迁移),例如TikTok将高频访问视频动态迁移到边缘节点

九八云安全

九八云安全